ChatGPT的智能还不如猫狗?

2023/02/15

比如,当询问ChatGPT“洛杉矶湖人队(Los Angeles Lakers)最近一场比赛的上场阵容”时,得到的回答是“我只具备2021年之前的知识,无法回答您的问题”。

谷歌和微软的对话AI同时使用网络搜索,因此会在信息的同步性和准确性方面取得巨大进步。尽管如此,谷歌在2月8日进行Bard的演示时,仍显示出了错误信息,说是美国航空航天局(NASA)的詹姆斯韦伯太空望远镜成功拍摄到了史上第一张太阳系外行星的照片。这一错误信息随后引发争议。可见,信息的准确性仍有不少课题需要解决。

缺乏常识和逻辑

除了上述的问题外,对话AI还存在根本性的课题。目前推出的对话AI基本上都很难说已经可以理解自己所使用的词汇的概念、含义、事物或现象的因果关系等“逻辑”。正因为如此,才会反复出现简单的事实误认。

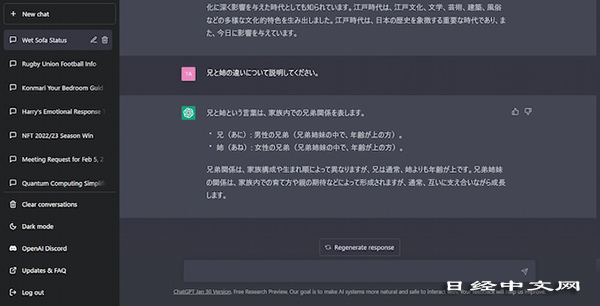

例如,向ChatGPT询问“哥哥和姐姐有什么不同”时,得到的回答是“虽然兄弟姐妹关系因家庭结构和出生顺序不同而存在差异,但哥哥通常比姐姐年龄大”。之所以给出这样不知所以然的答案,是因为没有“理解”哥哥、姐姐等词语的概念、相互之间的关系、家庭构成等全局情况。

|

| 向ChatGPT询问“哥哥”和“姐姐”的区别时,得到的回答含有错误内容 |

之所以会出现这样的错误,是因为现在使用的绝大部分语言模型是机器学习型AI。因此,使用的语言基本上是单词和短语的“排列”,机器通过读入数量庞大的过去的文献来识别排列类型。然后再计算出各类型出现的概率,寻找出接在问题之后的概率较高的字符串并加以显示。

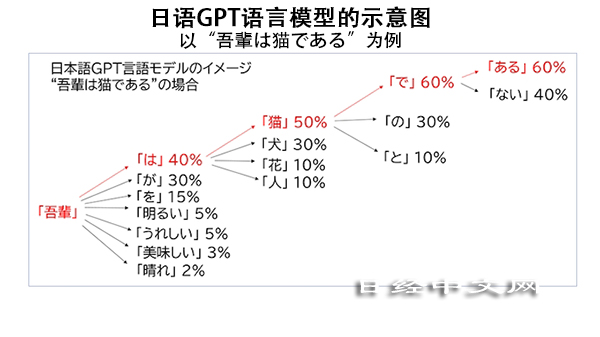

例如,在日语语言模型中输入“我が輩(中文译:我)”,使其生成后续的语句时,答案就会显示在书籍、新闻报道、网站留言中出现概率最高的排列组合类型,即“は猫である(中文译:是猫)”(见下图)。ChatGPT还可以直接生成与“夏目漱石风格”的小说相类似的句子。

(编者注:《我が輩は猫である》是日本作家夏目漱石的长篇代表作,中文译名为《我是猫》)

|

| 语言模型是“学习”在基本单词之后衔接什么单词的概率,并生成句子。(资料由NTT数据尖端技术提供) |

简单计算也会出错

也就是说,聊天AI不过是根据读取数据找出概率高的词序,并不是理解单词、语句的“含义”以及家庭成员之间的关系等“常识”。因此,它不擅长回答那些不理解意义和常识就难以回答的问题。

版权声明:日本经济新闻社版权所有,未经授权不得转载或部分复制,违者必究。

报道评论

金融市场

| 日经225指数 | 28493.47 | 336.50 | 04/14 | close |

| 日经亚洲300i | 28493.47 | 336.50 | 04/14 | close |

| 美元/日元 | 132.42 | -0.60 | 04/14 | 15:15 |

| 美元/人民元 | 6.8381 | -0.0298 | 04/14 | 07:14 |

| 道琼斯指数 | 34029.69 | 383.19 | 04/13 | close |

| 富时100 | 7843.380 | 18.540 | 04/13 | close |

| 上海综合 | 3336.1530 | 17.7892 | 04/14 | 14:05 |

| 恒生指数 | 20405.12 | 60.64 | 04/14 | 14:04 |

| 纽约黄金 | 2041.3 | 30.4 | 04/13 | close |

・日本经济新闻社选取亚洲有力企业为对象,编制并发布了日经Asia300指数和日经Asia300i指数(Nikkei Asia300 Investable Index)。在2023年12月29日之后将停止编制并发布日经Asia300指数。日经中文网至今刊登日经Asia300指数,自2023年12月12日起改为刊登日经Asia300i指数。